Drie jaar geleden vroeg Peter Bannon aan Elon Musk: we willen een eigen chip ontwikkelen, dat levert een 20% kostenreductie op en minimaal 7x de performance. Ontwikkelkosten bedragen alleen wel een paar honderd miljoen. Op dat moment moest een strategische beslissing genomen worden: het risico over laten aan de markt of het eigen hef in handen nemen. Tesla heeft voor het laatste gekozen en nu drie jaar later wordt daar het resultaat van getoond.

In een behoorlijk lange presentatie gaat het bedrijf vandaag in diepte in op de nieuwe hardware waarmee alle auto's die op dit moment geproduceerd worden zijn uitgerust. Het bedrijf heeft onder leiding van Peter Bannon en Jim Keller, een duo ook verantwoordelijk voor de Apple A4 en A5 chips, een eigen neurale accelerator ontwikkeld.

De chip is 260mm2 groot en bevat 6 miljard transistoren verdeeld over cpu-, gpu-, geheugen-, isp-, h.265-video- en nna-clusters. De meeste van deze clusters zijn in licentie genomen van IP-producenten, maar de neural network accelerator (nna) is volledig zelf ontworpen. De chip wordt geproduceerd door Samsung, op een 14nm FinFet proces.

De chip is voornamelijk gemaakt om de beelddata van de 8 verschillende camera's te kunnen verwerken. Als eerste moet de chip alle camera data in kunnen lezen, en daarvoor is een seriële camera-interface, vermoedelijk die van MIPI, aanwezig die 2,5 miljard pixels per seconden aan kan. Als alle 8 camera's in volledige resolutie (1280x960) op 60fps worden uitgelezen, is slechts 590 MP/s nodig, dus dit systeem lijkt flink over gedimensioneerd.

Vervolgens moet all die data verwerkt worden, wat met 1 gigapixel per seconde gaat, in een 24-bit pijplijn (8 bits voor elk van de 3 kleuren). In dit process kan tone mapping en ruisreductie toegepast worden.

Al deze data moet door het geheugensysteem heen, wat bestaat uit lpdd4 met een 128-bits bus. Elke pin kan 4,266 Gb/s aan, goed voor 68 GB/s in totaal.

Deze beelden zijn echter nutteloos als er niks mee gedaan wordt, en dat is waar de neural network processor komt kijken. Deze bestaat uit twee eenheden, elk met 9216 multiple-add eenheden, in een 96x96 grid. Deze draaien op 2 GHz, en als beide operaties apart worden gerekend kom je dus uit 36 biljoen operaties per seconden.

De eenheden moeten dus ook met erg veel data gevoed worden, waarvoor 32 MB sram aanwezig is. Een groot voordeel van sram is de lage latency, wat vermoedelijk ook de reden is geweest voor de keus van ddr4 in plaats van gddr of hbm. Pooling hardware zorgt dat data efficient en geordend het 96x96 grid in gaat. Verder is er een rectified linear unit aanwezig.

Soms kan het handig zijn om de video's te bewaren of door te sturen naar Tesla. In beide gevallen is het handig als je geen rauwe video van gigabytes per seconde hoeft te bewaren, maar dit netjes gecomprimeerd hebt. Hiervoor is een hardwarematige h.265 aanwezig.

Tesla heeft een gpu ingebouwd in de chip, maar niet een bijzonder krachtig model, gezien het meeste werk door de nna's worden. De gpu kan 600 GFlops verwerken, in de vorm van zowel 32-bits als 16-bits kommagetallen. Een Mali-gpu van Arm ligt voor de hand, maar er wordt niet verder op in gegaan.

Voor alle verdere aansturing en overige berekeningen zijn twaalf Cortex-A72 cpu's van Arm ingebouwd. Dit is de tweede generatie grote 64-bits ARMv8 kern van het bedrijf, en deze draaien op 2,2 GHz.

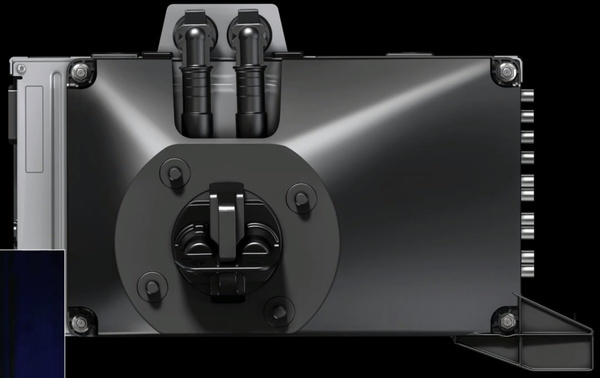

Elke Tesla bevat een boordcomputer met twee van deze chips. Elk van de chips wordt door vier geheugenchips van Micron vergezeld. Verder is er een redundante stroomvoorziening, waarmee beide systemen volledig redundant kunnen draaien.

De behuizing is vergelijkbaar met de vorige generatie en heeft het formaat van een broodtrommel. De 72 watt aan geproduceerde warmte wordt afgevoerd via waterkoeling, wat is aangesloten op het centrale koelsysteem van de auto. Indien kan deze hitte gebruikt worden om de batterij of de cabine op te warmen in koude omstandigheden.

Ondanks al deze nieuwe en krachtigere features, zijn de kosten van de nieuwe boordcomputer lager dan die van Nvidia. De marginale kosten moeten met 20% gedaald zijn, waarbij de ontwikkelkosten natuurlijk nog wel meegenomen moeten worden.

Als het bedrijf een nieuwe iteratie van zijn software wil testen, is het niet heel praktisch om een aantal Tesla's het kantoor binnen te rijden. Hierom heeft het bedrijf een serverchassis ontwikkeld waar vier van de boordcomputers in passen, en daarmee tientallen in een serverrek.

De Full Self-Driving computer is sinds vorige maand in productie in de Model S en Model X, en sinds ongeveer 10 dagen in de Model 3. Daarmee moet elke Tesla die nu in productie is alle geschikte hardware hebben om zelf te gaan rijden. De software is echter nog niet af, de neurale netwerken worden continue verder getraind om steeds meer complexe en onwaarschijnlijke situaties aan te kunnen.

Niet alleen is dit leuk voor bestaande en toekomstige eigenaren, het moet het hele bedrijfsmodel van Tesla overhoop gooien. Musk sprak over het Tesla Network, waarin de auto's volledig zelfstandig als robotaxi moeten kunnen functioneren. Omdat de kosten van chauffeurs wegvallen en die van elektriciteit een stuk lager liggen dan fossiele brandstoffen, zouden de robotaxi's per kilometer goedkoper moeten worden dan het zelf bezitten, onderhouden en voltanken van een brandstofauto. Via een software-update zouden dan de honderdduizenden Tesla's die de nieuwe hardware hebben in een klap zelf kunnen gaan rijden.

Dit weerhoudt het bedrijf er echter niet van om niet verder in de toekomst te kijken. Het ontwerp van de chip is 2 jaar geleden vastgelegd, op dat moment waren vele IP-onderdelen (zoals de cpu, gpu en video encoder) nog niet op kleinere processen verkrijgbaar. De volgende generatie chip moet over 2 jaar in productie gaan en bevat volgens Musk 'alle voor de hand liggende dingen voor een volgende generatie chip'. Dit antwoord kwam na een vraag over het gebruikte 14nm proces, wat erop duidt dat dit wel eens 7nm zou kunnen gaan worden.

Bron: Tesla (Youtube)