Nvidia's marketing in de hoogste versnelling: RTX-Ops

Inmiddels zal duidelijk zijn dat bij het renderen van een moderne game die gebruik maakt van real-time raytracing alle drie de soorten cores in gebruik zijn. De conventionele shader-cores (Cuda-cores in Nvidia-jargon) doen nog altijd het meeste werk, maar voor de raytracing effecten worden de RT-cores bijgeschakeld en voor het uiteindelijk afmaken van een frame komen ook nog de Tensor-cores om de hoek kijken.

Traditioneel konden Nvidia (en AMD) als simpele maat voor de prestaties van hun kaarten het maximale aantal floating-point operaties dat hun shader cores per seconde kunnen uitvoeren aanhouden, de zogenaamde Teraflops. Maar in een wereld met shader-cores, RT-cores en Tensor-cores is dat natuurlijk niet meer het complete verhaal. Tegelijkertijd is de maximale rekenkracht van de drie verschillende cores bij elkaar optellen ook onzinnig; enerzijds omdat de prestaties van de RT-cores überhaupt niet in Teraflops is uit te drukken, anderzijds omdat er nu binnen de shader-cores ook rekeneenheden zijn die helemaal niet met floating point getallen werken. Bovenal kunnen bij de Turing-chips zoals beschreven de drie chiponderdelen niet alle drie tegelijkertijd op volle kracht werken. De marketing dames en heren willen echter toch graag het niveau van prestaties van de kaarten in één getal vangen. Wat doe je dan? Dan bedenk je zelf maar wat... en dat zijn de zogenaamde RTX-Ops.

Marketing BS

Het hele concept van RTX-Ops is misschien wel de grootste - excusez le mot - marketing bullshit die we sinds tijden van Nvidia hebben gehoord, maar omdat de waardes prominent getoond zullen gaan worden op de dozen van RTX 20-serie kaarten en Nvidia de nieuwe "eenheid" actief wil gaan gebruiken, doen we toch maar even uit de doeken hoe het werkt.

In de "nieuwe wereld" zullen games, zoals op de vorige pagina's besproken, hybride worden gerenderd. Het gros van de scène wordt neergezet via rasterization. Parallel daaraan doen de RT-cores berekeningen voor belichtingseffecten, waarbij er integer én floatingpoint berekeningen van de shader cores nodig zijn om die te verwerken. Ten slotte schieten de Tensor-cores aan voor post-processing, zoals het opschonen van incomplete raytracing-berekingen. Veel zaken kunnen parallel, sommige zaken moeten achter elkaar en hoewel op meerdere momenten twee (of meer) onderdelen van de SM's actief zijn, zijn ze nooit allemaal tegelijkertijd actief.

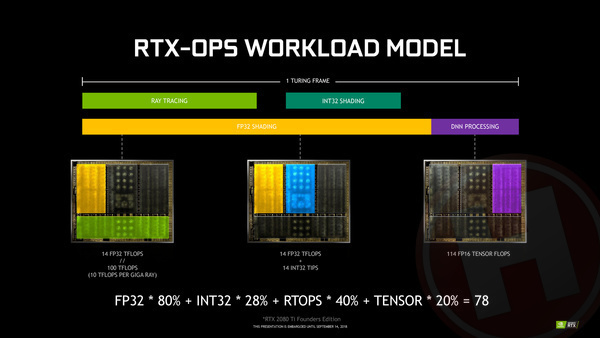

Nvidia heeft becijferd dat in een "gemiddeld" scenario - waarbij het überhaupt twijfelachtig is hoe gemiddeld dit is, aangezien er simpelweg nog geen RTX-games beschikbaar zijn - de floating point shader cores 80% van de tijd actief zijn, de integer shader cores 28% van de tijd, de RT-cores 40% van de tijd en de Tensor-cores 20% van de tijd. Nvidia's oplossing? Pak de maximale verwerkingssnelheid van alle onderdelen, vermenigvuldig ze met deze percentages, tel het bij elkaar op en je hebt een maat voor de snelheid.

Dat FP32 en INT32 operaties echt wel iets anders zijn, dat van de Tensor-cores FP16-waardes worden meegenomen en dat je de snelheid van de RT-cores überhaupt niet in flops kunt uitdrukken en dat Nvidia daarom maar stelt dat ze 10 Tflops per gigaray doen omdat RT-cores 10x sneller zijn dan shader cores voor deze workload, moeten we volgens de fabrikant maar door de vingers zien. Iedereen met ook maar enige wetenschappelijke achtergrond zal inmiddels jeuk hebben.

Hoe dan ook, voor de RTX 280 Ti kom je zo op 0,80 * 14 + 0,28 * 14 + 0,40 * 100 + 0,20 * 114 = 77,92, afgerond 78. En zo komt met dus voor de RTX 2080 Ti voor 78 tera van de zelf bedacht RTX-Ops, tegen 60T RTX-Ops voor de RTX 2080 en 45T RTX-Ops voor RTX 2070.

Duidelijk? Mooi, dan mag je wat ons betreft deze onzin snel weer vergeten.

3 besproken producten

| Vergelijk | Product | Prijs | |

|---|---|---|---|

|

Nvidia GeForce RTX 2070 8GB

|

Niet verkrijgbaar | |

|

Nvidia GeForce RTX 2080 8GB

|

Niet verkrijgbaar | |

|

Nvidia GeForce RTX 2080 Ti 11GB

|

Niet verkrijgbaar |