Tensor-cores: slimme trucs met AI

Zoals in het begin van dit artikel al geschreven zijn de RT-cores niet de enige rekeneenheden van een nieuwe soort binnen de Turing-chips. De gpu's bevatten daarnaast ook zogenaamde Tensor-cores, die geschikt zijn voor het versnellen van machine learning / kunstmatige intelligentie algoritmes. Die Tensor-cores komen we overigens bij Turing niet voor de eerst tegen: de Nvidia Volta-generatie, puur gebruikt voor professionele kaarten en voor de peperdure Titan V, had ook al Tensor-cores aan boord.

Machine learning

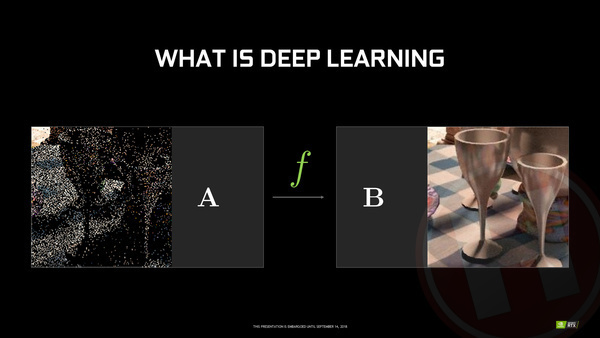

Eerst nog even een korte toelichting; machine learning is de hippe naam voor het concept om een computer zélf een programma/algoritme voor iets te laten bedenken door iets heel vaak voor te doen en het systeem daardoor te "trainen". Het mooiste voorbeeld is het herkennen van afbeeldingen: wanneer je een programma wil schrijven dat op foto's herkent of er een hond of poes op staat, zullen zelfs de slimste programmeurs ter wereld daar een enorme kluif aan hebben en na maanden programmeren met een algoritme komen dat nog steeds zeer geregeld de mist in gaat. In de wereld van machine learning toon je een computer duizenden, tienduizenden en liefst honderdduizenden foto's waarvan je direct meegeeft of het een poes of hond is ,en op basis van al die input ontwikkelt het systeem zélf een algoritme. Hoe meer data je erin stopt, hoe beter de uiteindelijke resultaten. Machine learning wordt inmiddels overal en nergens toegepast; van het herkennen van foto's bij diensten als Google Photos, via het snappen van commando's bij Amazon's Alexa tot aan het inschatten van verkeerssituaties in zelfrijdende auto's als die van Tesla.

Inferencing

Het trainen van een machine learning algoritme is zeer complex en tijdrovend, en gebeurt in de regel op super-computers in datacenters (waar Nvidia maar al te graag haar professionele Tesla-kaarten voor levert). Het toepassen van machine learning algoritmes, inferencing in jargon, is ook complex, maar veel gelukkig veel minder en kan ook op clients gebruiken. De Tensor-cores in de Turing-gpu's versnellen dit inferencing.

Wanneer je het plat slaat, is inferencing niet meer en niet minder dan input op hoge snelheid vergelijken met een uitvoerig uitgedokterde database van bestaande data. Onderliggend zijn chips die machine learning algoritmes uitvoeren de facto consequent matrixen van getallen met elkaar aan het vermenigvuldigen. Dat is een taak die shader cores binnen gpus vanwege de hoge parallelliteit al een stuk beter kunnen dan cpu's, maar specifiek voor deze taak gemaakte cores doen het nóg veel sneller. De zogenaamde Tensor-cores kunnen in één stap matrixen vermenigvuldigen en delen, waar shader cores hiervoor veel meer stappen nodig hebben. Op die manier kunnen machine learning algoritmes bestemd voor kunstmatige intelligentie (AI) met Tensor-cores flink versneld worden.

Nut in games?

Wat is daar het praktisch nut van? In principe kunnen zo'n beetje alle algoritmes die gebruik maken van machine learning door Tensor-cores versneld worden en stelt het programmeurs van software van allerlei soorten software in staat om via de verschillende door Nvidia beschikbaar gestelde API's op de Tensor-cores in te haken. Bij GeForce kaarten is het primaire doel natuurlijk gaming en ook op dit vlak is er voldoende wat de cores kunnen bijdragen.

Een belangrijk voorbeeld is al genoemd op de vorige pagina's: de GeForce RTX kaarten hebben weliswaar ondersteuning voor het versnellen van raytracing, maar snel genoeg om volledige games te raytracen zijn de chips bij lange na nog niet. Zelfs wanneer raytracing voor een beperkt aantal effecten wordt toegepast, kan het aantal lichtstralen dat binnen de rendertijd van één frame kan worden gevolgd te beperkt zijn om een vlekkeloos plaatje te krijgen. Nvidia gebruikt de eigen machine learning technologie en dus de Tensor-cores om het eindresultaat dan op te schonen. Of het zo is kunnen we niet controleren, maar Nvidia vertelde ons dat de Pixars van deze wereld ook al vergelijkbare technologieën gebruiken om rendertijden binnen de perken te houden.

DLSS: AI-powered anti-aliasing

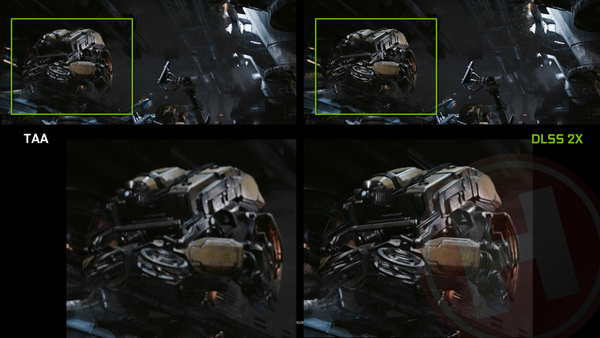

Maar, er is meer. We weten allemaal dat wanneer je een game in native resolutie van je monitor rendert, er zeker aan de randen van objecten nare artefacten kunnen ontstaan als kartelranden. Al sinds jaar en dag bieden videokaarten allerhande anti-aliasing methodes om dit tegen te gaan en de beeldkwaliteit te verbeteren. De meest conventionele vorm is multi sample anti-aliasing (MSAA), waarbij de game in een hogere resolutie wordt gerenderd en daarna wordt teruggeschaald. Bij 4x MSAA worden dus 4x zoveel pixels berekend (3840x2160 bij een full hd-resolutie) wat de facto ook betekent dat voor veel onderdelen binnen de 3D-pipeline de werkdruk vier keer zo hoog is (met alle gevolg van dien voor de prestaties). Omdat conventionele MSAA ondanks de uitstekende resultaten wel erg veel prestaties kost, zijn er de afgelopen jaren allerhande andere technologieën bedacht, zoals bijvoorbeeld FXAA (Fast Approximate Anti-Aliasing, dat randen van objecten herkent en afvlakt) en TAA (Temporal Anti-Aliasing, dat data van opeenvolgende frames gebruikt om de beeldkwaliteit te verbeteren). Bij de GeForce RTX 20-serie krijgen we er een optie bij, DLSS, wat staat voor Deep Learning Super Sampling.

Wat er bij DLSS in principe gebeurt is dat game developers via machine learning een algoritme opbouwen om beelden zo goed mogelijk in resolutie te verhogen. Daartoe voeden ze het lerend systeem met zoveel mogelijk beelden die zowel in lage als hoge resolutie zijn gerenderd. Het systeem leert zichzelf hoe de beelden van de betreffende game het beste kunnen worden opgewaardeerd. Het leer-gedeelte gebeurt offline door de game-ontwikkelaar op super-computers van Nvidia. Het uiteindelijke algoritme wordt gebruikt in de game.

DLSS kan op twee manieren gebruikt worden. Als alternatief voor AA kan DLSS beelden opschalen en daarna terugschalen, waarmee je een soort MSAA krijgt, maar dan met veel minder werkdruk voor de shader cores. Maar DLSS kan ook gebruikt worden wanneer je videokaart bijvoorbeeld niet krachtig genoeg is voor de resolutie van je monitor; zo kan een game native gerenderd worden in Full HD en daarna via DLSS zo goed mogelijk worden opgewaardeerd naar 4K.

Het klinkt als magie, maar werkt wel degelijk. Tijdens het introductie-evenement toonde Nvidia ons diverse testopstellingen met links een GeForce GTX 1080 met 4x MSAA en rechts een GeForce RTX 2080 met DLSS. Het resultaat: in de regel zo'n 2x hogere framerate en een beeldkwaliteit die in ieder geval door ondertekende niet te onderscheiden was.

Om DLSS te gebruiken moet er dus een machine learning algoritme getraind worden dat specifiek is geoptimaliseerd voor de betreffende game. Nvidia zegt dat men deze dienst gratis aanbiedt aan game-developers. Zij kunnen dus gratis gebruik maken van de super-computers van Nvidia. De reden lijkt ons duidelijk: hoe meer games DLSS gebruiken, hoe meer munitie Nvidia heeft om de GeForce RTX kaarten aan te prijzen.

3 besproken producten

| Vergelijk | Product | Prijs | |

|---|---|---|---|

|

Nvidia GeForce RTX 2070 8GB

|

Niet verkrijgbaar | |

|

Nvidia GeForce RTX 2080 8GB

|

Niet verkrijgbaar | |

|

Nvidia GeForce RTX 2080 Ti 11GB

|

Niet verkrijgbaar |